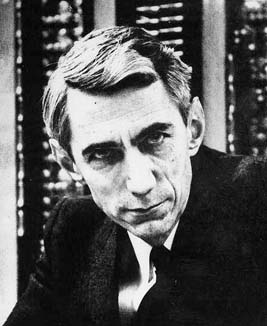

Claude Shannon

1916-2001

Le regard de Claude Shannon 1916-2001 à

un disque compact sous un microscope et

vous verra la musique représentée comme

ordre des puits, ou en termes

mathématiques, comme ordre de 0 et de 1,

généralement désigné sous le nom du

peu. La base de notre âge de

l'information est cette transformation de

la parole, de l'acoustique, des images et

de la vidéo dans le contenu numérique,

et l'homme qui a commencé la révolution

numérique était Claude Shannon, qui est

mort février 24, à l'âge de 84, après

une longue lutte avec la maladie

d'Alzheimer.  Shannon est

arrivé à l'idée révolutionnaire de la

représentation numérique en prélevant

l'émetteur d'informations à un taux

approprié, et convertissant les

échantillons en peu coulent. Il a

caractérisé la source par un nombre

simple, l'entropie, adaptant une limite

de mécanique statistique, pour mesurer

la teneur en information de la source.

Pour le texte d'anglais, Shannon a

regardé l'entropie comme paramètre

statistique qui a mesuré combien

d'information est produite sur la moyenne

par chaque lettre. Il a également créé

la théorie de codage, en présentant la

redondance dans la représentation

numérique pour se protéger contre la

corruption. Shannon est

arrivé à l'idée révolutionnaire de la

représentation numérique en prélevant

l'émetteur d'informations à un taux

approprié, et convertissant les

échantillons en peu coulent. Il a

caractérisé la source par un nombre

simple, l'entropie, adaptant une limite

de mécanique statistique, pour mesurer

la teneur en information de la source.

Pour le texte d'anglais, Shannon a

regardé l'entropie comme paramètre

statistique qui a mesuré combien

d'information est produite sur la moyenne

par chaque lettre. Il a également créé

la théorie de codage, en présentant la

redondance dans la représentation

numérique pour se protéger contre la

corruption.

Si

aujourd'hui vous prenez un disque compact

dans une main, prenez une paire des

ciseaux dans l'autre main, et marquez le

disque le long d'un rayon du centre au

bord, alors vous constaterez que les jeux

de disque toujours comme si nouveau.

Avant

Shannon, on l'a généralement cru que la

seule manière de réaliser

arbitrairement la petite probabilité de

l'erreur dans une  voie de transmission

était de ramener le taux de transmission

à zéro. Tout ceci a changé en 1948

avec la publication d'une théorie

mathématique de communication, où

Shannon a caractérisé un canal par un

paramètre simple; la capacité de canal,

et prouvé qu'il était possible de

transmettre l'information en tout cas

au-dessous de la capacité avec une

probabilité arbitrairement petite

d'erreur. Sa méthode de preuve était de

montrer l'existence d'un bon code simple

en faisant la moyenne au-dessus de tous

les codes possibles. voie de transmission

était de ramener le taux de transmission

à zéro. Tout ceci a changé en 1948

avec la publication d'une théorie

mathématique de communication, où

Shannon a caractérisé un canal par un

paramètre simple; la capacité de canal,

et prouvé qu'il était possible de

transmettre l'information en tout cas

au-dessous de la capacité avec une

probabilité arbitrairement petite

d'erreur. Sa méthode de preuve était de

montrer l'existence d'un bon code simple

en faisant la moyenne au-dessus de tous

les codes possibles.

Son papier a établi des limites

fondamentales sur l'efficacité des

canaux bruyants d'excédent de

communication, et a présenté le défi

de trouver des familles des codes qui

réalisent la capacité. La méthode de

codage aléatoire ne produit pas un

exemple explicite d'un bon code, et en

fait cela a pris cinquante ans pour que

les théoriciens de codage découvrent

les codes qui viennent près de ces

limites fondamentales sur des canaux de

ligne téléphonique.

L'importance

du travail de Shannon a été identifiée

immédiatement. Selon un numéro 1953 de

magazine de fortune: "ce peut

n'être aucune exagération pour dire que

le progrès de l'homme dans la paix, et

la sécurité dans la guerre, dépendent

davantage  des applications

fructueuses de théorie de l'information

que sur des démonstrations physiques,

dans les bombes ou aux centrales, que

l'équation célèbre d'Einstein

fonctionne". En fait son travail a

le temps fini plus important devenu avec

l'arrivée de la communication profonde

de l'espace, des téléphones sans fil,

des réseaux informatiques à grande

vitesse, de l'Internet, et des produits

comme des joueurs de disque compact, des

commandes dures, et des modems à grande

vitesse qui font l'utilisation

essentielle de la compression de codage

et de données d'améliorer la vitesse et

la fiabilité. Shannon a grandi dans

Gaylord Michigan, et a commencé son

éducation à l'université du Michigan,

où il majored dans des mathématiques et

l'électrotechnique. En tant qu'étudiant

gradué au MIT, sa connaissance des

mathématiques de l'algèbre booléenne

et de la pratique de la conception de

circuit a produit ce que H.h. Goldstine a

appelé: "un des thèses du maître

le plus important jamais écrites... une

borne limite parce qu'elle a changé la

conception de circuit d'un art en

science". Cette thèse, une analyse

symbolique des circuits de relais et de

commutation, écrite en 1936, si

techniques mathématiques pour établir

un réseau des commutateurs et des relais

pour des applications

fructueuses de théorie de l'information

que sur des démonstrations physiques,

dans les bombes ou aux centrales, que

l'équation célèbre d'Einstein

fonctionne". En fait son travail a

le temps fini plus important devenu avec

l'arrivée de la communication profonde

de l'espace, des téléphones sans fil,

des réseaux informatiques à grande

vitesse, de l'Internet, et des produits

comme des joueurs de disque compact, des

commandes dures, et des modems à grande

vitesse qui font l'utilisation

essentielle de la compression de codage

et de données d'améliorer la vitesse et

la fiabilité. Shannon a grandi dans

Gaylord Michigan, et a commencé son

éducation à l'université du Michigan,

où il majored dans des mathématiques et

l'électrotechnique. En tant qu'étudiant

gradué au MIT, sa connaissance des

mathématiques de l'algèbre booléenne

et de la pratique de la conception de

circuit a produit ce que H.h. Goldstine a

appelé: "un des thèses du maître

le plus important jamais écrites... une

borne limite parce qu'elle a changé la

conception de circuit d'un art en

science". Cette thèse, une analyse

symbolique des circuits de relais et de

commutation, écrite en 1936, si

techniques mathématiques pour établir

un réseau des commutateurs et des relais

pour  réaliser une fonction

logique spécifique, telle qu'une serrure

de combinaison. Elle a gagné le prix

noble d'Alfred des sociétés machinantes

combinées des Etats-Unis et est

fondamentale dans la conception des

calculateurs numériques et des circuits

intégrés. L'intérêt de Shannon pour

la conception de circuit n'était pas

purement théorique, parce que il a

également aimé construire, et son sens

de jeu est évident dans plusieurs de ses

créations. Dans les années 50, quand

des ordinateurs ont été donnés des

noms comme ENIAC (intégrateur et

calculatrice numériques électroniques)

Shannon a construit un ordinateur appelé

THROBAC qu'I (ordinateur Vers

l'arrière-regardant de Romain-numéro

économe), qui pouvait s'ajouter,

soustraient, multiplient et divisent

même des nombres jusqu'à 85

fonctionnant seulement avec les numéros

romains. Son étude dans Massachusetts de

Winchester a été remplie de tels

dispositifs, y compris une souris

mécanique desolution et une machine

miraculeuse de jonglerie. Traverser le

plafond était une chaîne tournante,

comme ceux aux nettoyeurs à sec,

desquels ont été suspendues les robes

d'une vingtaine de doctorates

honorifiques. Ils ont fait un vol

splendide de vue autour de la salle. La

dissertation doctorale de Shannon 1941,

sur la théorie mathématique de la

génétique, aussi bien n'est pas connue

en tant que thèse de son maître, et en

fait n'a pas été éditée jusqu'en

1993, d'ici là la plupart des résultats

avaient été obtenues indépendamment

par d'autres. Après avoir reçu un

diplôme du MIT, Shannon a passé une

année à l'institut pour l'étude

avançée, et c'est la période où il a

commencé à développer son cadre

théorique qui mènent à son papier 1948

sur la communication en présence du

bruit. Il a joint des laboratoires de

Bell en 1941, et est resté là pendant

15 années, après quoi il a renvoyé à

la guerre mondiale de MIT. During II son

travail sur le chiffrage mené au

système employé par Roosevelt et

Churchill pour des conférences

transoceanic, et réaliser une fonction

logique spécifique, telle qu'une serrure

de combinaison. Elle a gagné le prix

noble d'Alfred des sociétés machinantes

combinées des Etats-Unis et est

fondamentale dans la conception des

calculateurs numériques et des circuits

intégrés. L'intérêt de Shannon pour

la conception de circuit n'était pas

purement théorique, parce que il a

également aimé construire, et son sens

de jeu est évident dans plusieurs de ses

créations. Dans les années 50, quand

des ordinateurs ont été donnés des

noms comme ENIAC (intégrateur et

calculatrice numériques électroniques)

Shannon a construit un ordinateur appelé

THROBAC qu'I (ordinateur Vers

l'arrière-regardant de Romain-numéro

économe), qui pouvait s'ajouter,

soustraient, multiplient et divisent

même des nombres jusqu'à 85

fonctionnant seulement avec les numéros

romains. Son étude dans Massachusetts de

Winchester a été remplie de tels

dispositifs, y compris une souris

mécanique desolution et une machine

miraculeuse de jonglerie. Traverser le

plafond était une chaîne tournante,

comme ceux aux nettoyeurs à sec,

desquels ont été suspendues les robes

d'une vingtaine de doctorates

honorifiques. Ils ont fait un vol

splendide de vue autour de la salle. La

dissertation doctorale de Shannon 1941,

sur la théorie mathématique de la

génétique, aussi bien n'est pas connue

en tant que thèse de son maître, et en

fait n'a pas été éditée jusqu'en

1993, d'ici là la plupart des résultats

avaient été obtenues indépendamment

par d'autres. Après avoir reçu un

diplôme du MIT, Shannon a passé une

année à l'institut pour l'étude

avançée, et c'est la période où il a

commencé à développer son cadre

théorique qui mènent à son papier 1948

sur la communication en présence du

bruit. Il a joint des laboratoires de

Bell en 1941, et est resté là pendant

15 années, après quoi il a renvoyé à

la guerre mondiale de MIT. During II son

travail sur le chiffrage mené au

système employé par Roosevelt et

Churchill pour des conférences

transoceanic, et  a inspiré son

travail pilote sur la théorie

mathématique de cryptography. C'était

aux laboratoires de Bell que Shannon a

produit la série de papiers qui ont

transformé le monde, et qui la

transformation continue aujourd'hui. En

1948, Shannon reliait la théorie et la

physique de l'information en développant

sa nouvelle perspective sur l'entropie et

sa relation aux lois de la

thermodynamique. Que le raccordement

évolue aujourd'hui, car d'autres

explorent les implications du quantum

calculant, en agrandissant la théorie de

l'information pour traiter la

transmission et le traitement des états

de quantum. Shannon doit se ranger près

du dessus de la liste des figures

principales de la vingtième science de

siècle, bien que son nom soit

relativement inconnu au grand public. Son

influence la vie quotidienne, qui est

déjà énorme, peut seulement augmenter

au fil du temps. a inspiré son

travail pilote sur la théorie

mathématique de cryptography. C'était

aux laboratoires de Bell que Shannon a

produit la série de papiers qui ont

transformé le monde, et qui la

transformation continue aujourd'hui. En

1948, Shannon reliait la théorie et la

physique de l'information en développant

sa nouvelle perspective sur l'entropie et

sa relation aux lois de la

thermodynamique. Que le raccordement

évolue aujourd'hui, car d'autres

explorent les implications du quantum

calculant, en agrandissant la théorie de

l'information pour traiter la

transmission et le traitement des états

de quantum. Shannon doit se ranger près

du dessus de la liste des figures

principales de la vingtième science de

siècle, bien que son nom soit

relativement inconnu au grand public. Son

influence la vie quotidienne, qui est

déjà énorme, peut seulement augmenter

au fil du temps.

Robert Calderbank et Neil

J. A. Sloane

|